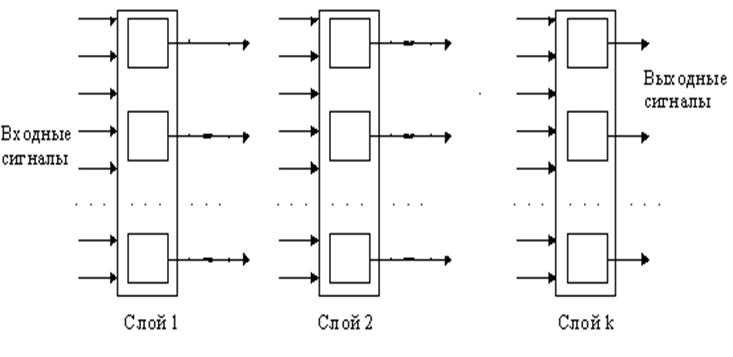

Рисунок 1 - Прямонаправленная сеть

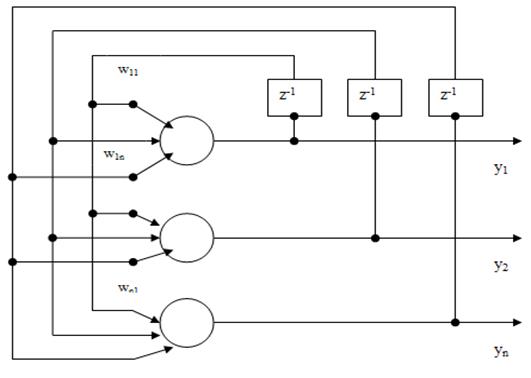

В полносвязных сетях каждый нейрон передает свой выходной сигнал остальным нейронам, включая самого себя (рис.2). Выходными сигналами сети могут быть все или некоторые выходные сигналы нейронов после нескольких тактов функционирования сети. Все входные сигналы подаются всем нейронам. Для полносвязной сети входной сумматор нейрона фактически распадается на два: первый вычисляет линейную функцию от входных сигналов сети, второй – линейную функцию от выходных сигналов других нейронов, полученных на предыдущем шаге.

Рисунок 2 - Полносвязная сеть

1.2 Обучение нейронных сетей

Возможно, самым удобным принципом классификации ИНС являются парадигмы их обучения (иначе, правила изменения и регулирования весов). Существуют три основных парадигмы обучения:

· супервизорное обучение (СО);

· несупервизорное обучение (НСО);

· усиленное обучение (УО).

СО - сегодня наиболее часто используемый вид обучения сетей и используется в ИНС, предназначенных для классификации и предсказания. НСО применяется в задачах кластеризации и сегментации для поддержки принимаемого решения. УО находит применение в задачах оптимизации и адаптивного управления и по сравнению с другими способами обучения используется реже.

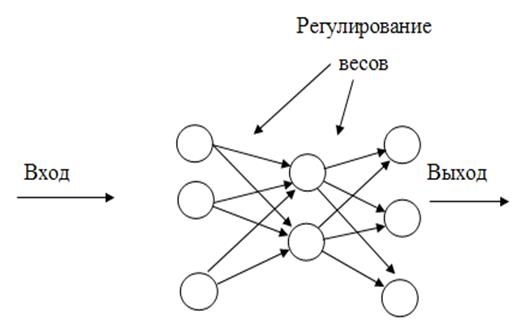

Наиболее распространенным является первый способ. Этот вид обучения эквивалентен программированию на примерах. При таком подходе сети задается проблема, и ИНС ищет решение по известному соотношению «вход-выход». Здесь «учитель» (тренер) указывает, каким должен быть правильный ответ. Обучающий алгоритм по разнице между правильным (требуемым) выходом и действительным выходом сети регулирует ее веса таким образом, что в следующий момент времени (на следующем проходе) выход сети будет ближе к правильному ответу. На входной слой сети подается вектор входных параметров, а на выходной - соответствующий этому вектору номер класса (в задаче классификации). Такие примеры «вход-выход» сети должны быть предъявлены десятки раз прежде, чем сеть может дать точный ответ на некоторую сложную проблему (например, отнести новый, неизвестный сети объект к одному из классов, на которые она обучена) (рис.3).

СО обычно используется, когда в наличии имеется база данных примеров, содержащие вход и выход. По этой базе ИНС может обучиться тому, как связаны вход и выход, и на основании этого принять соответствующее решение. Сеть тренируется на предъявляемых ей учителем примерах. Цель такой тренировки заключается в минимизации ошибки между правильным и реальным выходами сети.

Рисунок 3 - Схема супервизорного обучения

Переход к многослойным нейронным сетям, способным решать задачи классификации, был затруднен из-за отсутствия обучающего алгоритма для таких сетей. Метод обучения многослойных сетей, получивший название метода обратного распространения ошибки (ОРО, в английском написании - BackPropagationError (BPE)), был предложен в 1986 г., после чего начался интенсивный период разработки нейросетевых технологий на основе многослойных сетей в приложениях к различным сферам науки и техники. Здесь рассмотрим метод ОРО для многослойного прямонаправленного персептрона (МПП), предназначенного для решения задач, которые могут быть выражены в виде образов (пар) вход - выход. Такие соотношения можно назвать обучающими примерами.

Обучение МПП состоит в адаптации всех синаптических весов таким образом, чтобы разница между действительными выходными и требуемыми сигналами, усредненная по всем обучающим примерам, была настолько мала, насколько это возможно. Обучение сети методом ОРО включает в себя три этапа:

- прямое распространение входного обучающего образа;

Уважаемый посетитель!

Чтобы распечатать файл, скачайте его (в формате Word).

Ссылка на скачивание - внизу страницы.