![]() (1.13-14.27.а)

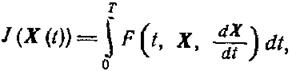

(1.13-14.27.а)

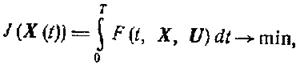

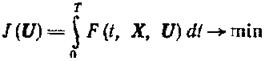

и минимизирующую функционал

(1.13-14.28.а)

(1.13-14.28.а)

(1.13-14.28.b)

(1.13-14.28.b)

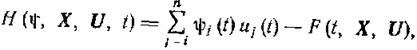

где ![]()

Функция

где Ψ(t) = {ψ1(t), ψ2(t),..., ψn(t)} - некоторая вектор-функция, заданная на отрезке [0, Т], называется функцией Гамильтона для задачи (1.13-14.27.), (1.13-14.28.).

Как вытекает из вышеизложенного, необходимое условие достижения минимума функционала J(X(t)) может быть сформулировано следующим образом. Пусть функция F(t,X,U) непрерывно дифференцируема, как функция своих аргументов. Если непрерывно дифференцируемая вектор-функция х°(t) является решением задачи, то существуете непрерывная вектор-функция Ψ°(t) = {ψ°1(t), ψ°2(t),..., ψ°n(t)} такая, что пара Х°(t), Ψ°(t) удовлетворяет следующим условиям:

1.13-14.3. Прямые методы решения задач оптимального управления.

При знакомстве с основными понятиями теории автоматического управления упоминалось в общих чертах о задачах оптимального управления. Кратко вспомним.

Оптимальная программа Х°, U° определяется как решение вариационной задачи

(1.13-14.34)

(1.13-14.34)

при условиях

![]() (1.13-14.35)

(1.13-14.35)

![]() (1.13-14.36)

(1.13-14.36)

где U — фиксированное множество векторов управления, U(t) принадлежит к не которому классу функций

![]() (1.13-14.37)

(1.13-14.37)

Напомним, что вектор-функция U — находящееся в нашем распоряжении управление.

Методы расчета оптимальных программ принято разделять на два класса. К первому относятся прямые методы, которые используют тот или иной способ редукции (сведения сложного к более простому) вариационной задачи (1.13-14.34.)-(1.13-14.37.) к конечномерной задаче математического программирования. Ко второму классу относятся методы, использующие необходимые условия. Эта классификация достаточно условна, так как при решении конкретных задач оба класса методов часто дополняют друг друга, тем не менее, она удобна, поскольку показывает существенное различие в подходах к решению рассматриваемых задач.

Проиллюстрируем это на простейшем примере отыскания минимума функции f(X). Прямые методы (в научной литературе эти методы носят названия методов спуска. Среди них выделяют метод градиентного спуска, метод оврагов и др.) основываются на идее построения некой итерационной последовательности

![]() (1.13-14.38)

(1.13-14.38)

где gk -

вектор, указывающий некоторое направление убывания функции f в

точке Xk, a αk - итерационный

параметр, величина которого указывает длину шага в направлении gk.

Обычно в качестве вектора gk выбирают вектор

где gk -

вектор, указывающий некоторое направление убывания функции f в

точке Xk, a αk - итерационный

параметр, величина которого указывает длину шага в направлении gk.

Обычно в качестве вектора gk выбирают вектор  противоположный градиенту f(X),

который, как известно, является нормалью к поверхности уровня f(X)=с

(с - некая константа) в сторону наибольшего уменьшения функции.

противоположный градиенту f(X),

который, как известно, является нормалью к поверхности уровня f(X)=с

(с - некая константа) в сторону наибольшего уменьшения функции.

Схематически вычислительная процедура строится следующим образом. Пусть Х° - вектор (точка в n-мерном пространстве), задающий минимум f(X), а Х0 - его нулевое приближение. Через точку Х0 (точка М0) проведем поверхность уровня функции f(X)=f(X0). Если точка Х0 достаточно близка к искомой точке X, то поверхность уровня f(X)=f(X0) будет похожа на эллипсоид.

Из точки Х0 двигаемся по нормали к этой поверхности в сторону убывания до тех пор, пока эта нормаль не коснется в некоторой точке X1 какой-либо другой поверхности уровня (рисунок 1.13-14.2.): f(X)=f(X1). Затем, отправляясь от точки X1, вновь повторяем эту процедуру и т. д. Так как f(X0) > f(X1) > f(X2), ..., то, двигаясь по такому пути, мы быстро приближаемся к наименьшим значениям f(X°) (дно «ямы»). Величину шага αk на каждой итерации обычно выбирают из условия

![]() (1.13-14.39)

(1.13-14.39)

находя наименьшее положительное α.

Уважаемый посетитель!

Чтобы распечатать файл, скачайте его (в формате Word).

Ссылка на скачивание - внизу страницы.