1. Введение: системы передачи информации, их назначение

Данная дисциплина посвящена изучению методов и средств передачи информации в технических и организационных системах.

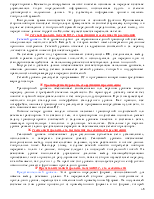

История развития

Обмен информацией между индивидами возник сразу с появлением языка.

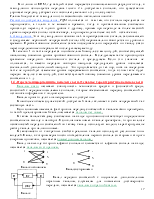

В 1795 году Кулибин выразил идею, согласно которой для передачи сообщений может быть использован оптический телеграф семафорного типа. Он представлял собой трех реечную конструкцию, установленную на высокой мачте. По средствам реек телеграфа можно было формировать порядка 100 визуальных символов или сообщений, которые расшифровывались с помощью специальных таблиц.

В 1820 году Ампер предложил передавать сигналы электрическим способом, с помощью проводов и магнитных стрелок.

В 1832 году российский ученый Шиллинг изобрел телеграфный аппарат, который обеспечивал передачу сообщений по семи проводам, а также изобрел электромагнитное реле.

В 1839 году Якобий разработал несколько вариантов телеграфных аппаратов и создал первый в мире буквопечатающий аппарат.

В 1842 году морской офицер Константинов построил автоматический электромеханический коммутатор.

В 1855 году американец Хьусов запатентовал телеграфный аппарат по принципу Якове.

В 1869 году профессор Краковского университета Морозов предложил метод частотного разделения сигналов.

В 1880 году капитан РА Игнатьев впервые осуществил одновременную передачу сигналов переменного и постоянного тока, что явилось первым опытом многоканальной передачи информации.

В 1894 году российские инженеры Постолов, Бердичевский и Фриденберг создали первую в мире автоматическую телефонную станцию.

После 1905 года появилась возможность использования радио, а затем и телеканалов.

2. Информация: сущность, основные понятия и свойства

В математической теории под информацией понимается упорядоченная количественно-оцениваемая совокупность материально-энергетических проявлений окружающего мира, способная быть объектом хранения, преобразования и передачи.

В соответствии с этим определением возникает вопрос о представительстве носителя, о носителях и о физической реализации информации, а также о способах ее измерения.

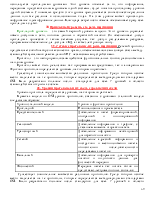

Свойства информации:

а) Информация обеспечивает получение новых сведений (знаний) об окружающих объектах и явлениях в соответствующей точке физического пространства и времени.

б) Информация в чистом виде не материальна сама по себе, но реализуется в форме материальных носителей (знаков или символов).

в) Информация может заключаться в виде материальных носителей как таковых, но и в их взаимном (пространственном или временном) расположении.

г) Знаки и символы несут информацию только получателю, способному их воспринимать и распознавать.

Знаками (символами) называют статические носители информации, представляющие собой устойчиво и однозначно распознаваемые получателем материальные объекты, а именно: буквы, цифры, условные обозначения.

Символами называют динамические процессы во времени, состоянии, физических полей любой природы, параметры которых выступают как определенные функции времени.

В качестве знаков (символов) чаще всего используют их большие совокупности в виде книг и аудио/видео записей. Знаки или символы используются, как правило, для накопления и хранения информации. Сигналы используют для передачи информации, т.е. для переноса ее из одной точки пространства в другую.

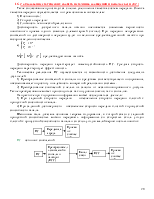

Сигналы могут быть непрерывными и дискретными. В первом случае сигналы реализуются в форме непрерывных во времени физических процессов. Во втором случае сигналы реализуются в виде кратковременных отклонений какого-либо физического процесса или одного из его параметров от исходного стационарного состояния.

Для непрерывных сигналов отличительным, т.е. информационным признаком является мгновенное значение величины контролирующего параметра в произвольный момент времени.

Для дискретных сигналов отличительными признаками могут являться амплитуда, полярность, длительность, фаза, частота следования импульсов.

Последовательность символов называется сообщением, каждый из символов или сигналов, в отдельности такие являются элементарным сообщением.

Сообщение и их упорядоченная совокупность несут получателю определенную информацию.

Множество символов либо сигналов, используемых для организации сообщений, называется алфавитом.

При передаче информации на расстояние между символами и сигналами должно быть установлено взаимнооднозначное соответствие.

Правила, по которым производится сопоставление символов данного алфавита с сигналами, используемыми для передачи сообщений или же с символами другого алфавита, называется правилом кодирования (кодом).

А сам процесс такого сопоставления, называется кодированием.

Процесс обратный произведенному кодированию называется декодированием.

Информационная ценность сообщений определяется для получателя тем, какую степень новизны они ему несут, т.е. наличием в них отличительных признаков от тех сообщений, которые были получены ранее.

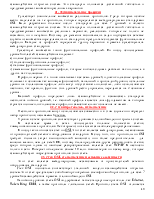

Существует наука о знаковых системах, которая называется семиотикой. Она включает в себя несколько разделов:

- семантика, которая занимается установлением связей между знаками и их смысловым содержанием;

- синтактика, которая устанавливает связи между знаками;

- стигматика, устанавливает взаимосвязи между знаками и объектами;

- прагматика, занимающаяся приложением, устанавливает связь между знаками и человеческой деятельностью как таковой.

При передаче информации в технических системах в последнее время наиболее часто используется термин или понятие передача данных.

Понятие информация является более широким и универсальным понятием, чем данные, так как под термином данные принято понимать способ представления информации в соответствующем формальном виде, позволяющем и облегчающем процесс передачи, обработки и хранения соответствующей информации.

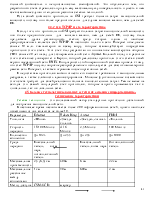

3. Способы измерения информации в информационных системах

Счетное множество дискретных элементов (символов), используемых для формирования дискретных сообщений, называется алфавитом, а элементы этого алфавита называются буквами.

Число букв в алфавите, называется объектом.

В дискретных моделях информационных систем минимальные неделимые элементы информации, называются квантами.

Геометрическая мера информации. В этом случае количество информации оценивается числом квантов, на которое может быть разбито данное информационное пространство в пределах заданных структурных габаритов.

Недостатком геометрической меры является зависимость количества информации от способа разбиения информационного пространства на элементарные ячейки.

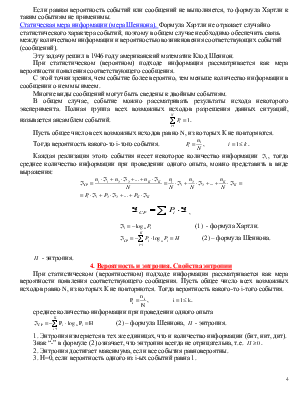

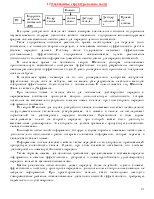

Комбинаторная мера информации. Эта мера используется в тех случаях, когда необходимо оценить возможность передачи информации, при помощи различных комбинационных информационных элементов. Образование таких комбинаций представляет собой один из способов кодирования.

В комбинаторной мере количество информации оценивается числом возможных комбинаций, которые можно сформировать из данных комбинационных элементов.

Уважаемый посетитель!

Чтобы распечатать файл, скачайте его (в формате Word).

Ссылка на скачивание - внизу страницы.