Выходная случайная величина y представляется как:

![]() Y = j(X1,X2,...,Xk ) + (X1,X2,...,Xk ) ,

Y = j(X1,X2,...,Xk ) + (X1,X2,...,Xk ) ,

где j(X1,X2,...,Xk ) - выборочная функция,

e (X1,X2,...,Xk ) - случайная составляющая (ошибка).

Регрессионная зависимость определяется условным математическим ожиданием: М[Y| х1,х2,...,хk к] = j( х1,х2,...,хk).

Простейшей зависимостью является линейная

зависимость y от одной переменной x: ![]()

Задача линейного регрессионного анализа заключается в расчете коэффициента а и b, наилучшим образом соответствующих результатам эксперимента. К линейным задачам могут быть приведены и некоторые нелинейные задачи за счет, например, операции логарифмирования.

y = а хb переходит в lg y = lg a + b lg x

y = ea+bx переходит в ln y = a + b x

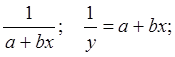

переходит в

переходит в

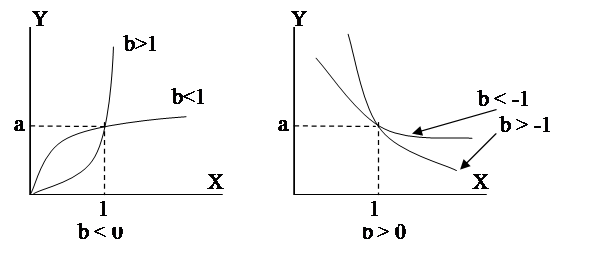

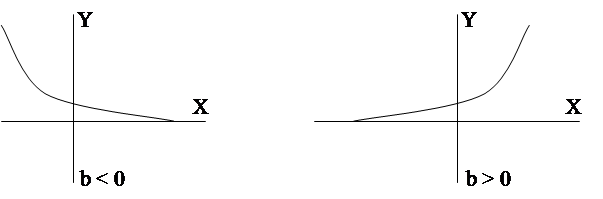

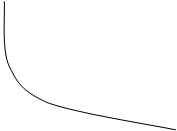

Решение таких нелинейных регрессионных задач сводится к решению линейных задач. Графики нелинейных характеристик, которые могут быть сведены к линейным, приведены на рис.8.

1) y =axb ; lg y = lg a +b lg x;

|

2) y = ea+bx ; ln y = a + bx ;

|

|

|

|

|

|

|

рис.8.

Нелинейные зависимости приводимые к линейным.

Решение задач регрессионного анализа обычно реализуется с помощью метода наименьших квадратов (МНК).

3.1.Метод наименьших квадратов.

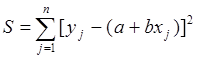

Так как величина y вычисляется всегда с некоторой ошибкой e, то можно вычислить среднее квадратичное отклонение:

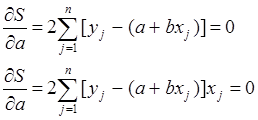

При использовании МНК среднеквадратичное

отклонение должно стремиться к минимальному. Так как функция S

зависит от а и b, нужно выбрать такие a и b,

чтобы ![]() т.е.

т.е.

|

![]()

![]() Эта система называется системой нормальных уравнений. Отсюда

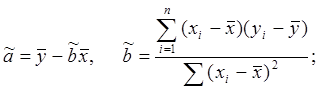

найдем оценки коэффициента и коэффициента .

Эта система называется системой нормальных уравнений. Отсюда

найдем оценки коэффициента и коэффициента .

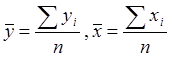

где

где

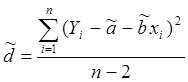

При этом оценка дисперсии ошибки :

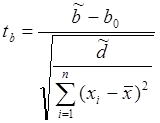

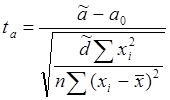

Можно определить доверительный интервал, и

другие гипотезы относительно коэффициентов ![]() и

и ![]() , так как ниже приведенные значения ta

и tb распределены по закону Стьюдента с (n – 2) степенями свободы.

, так как ниже приведенные значения ta

и tb распределены по закону Стьюдента с (n – 2) степенями свободы.

|

|||

|

|||

- сравнивается - сравнивается

с t0,975(n – 2) с t0,975(n – 2)

3.2.Модель множественной линейной регрессии.

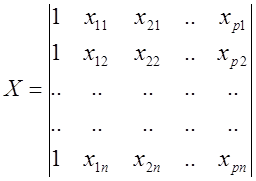

Если число входных величин xi равно р > 1, то результаты n измерений выходной величины y имеют вид:

y j = a0 + a1x1j + a2x2j + … + apxpj + ej ,

где e - ошибка измерения.

Эту зависимость удобно представить в

векторно матричной форме. Обозначим векторы – столбцы оценок коэффициентов ![]() , вектор результатов измерений

, вектор результатов измерений ![]() , вектор ошибок

, вектор ошибок ![]() :

:

Матрица значений xi j называется матрицей плана эксперимента

|

Уравнение множественной линейной регресии в матричной форме имеет вид:

![]() , откуда

, откуда ![]() .

.

Уважаемый посетитель!

Чтобы распечатать файл, скачайте его (в формате Word).

Ссылка на скачивание - внизу страницы.