|

S1* |

S2* |

Sj* |

Sm* |

|||

|

S1 |

||||||

|

S2 |

||||||

|

|

||||||

|

Sm |

P(Sj*/Si)

Если условная вероятность не зависит от времени и от того, какие сигналы передались ранее, то канал называют однородным без памяти. Математическим описанием канала с памятью является цепь Марноваю. Канал называют симметричным, если алфавиты входных и выходных сигналов одинаковы, а условные вероятности

P(Sj*/Si)=Po=const при i![]() ; m= m*

; m= m*

Алфавиты входных и выходных сигналов одинаковы, значит канальная матрица квадратная.

Для симметричного канала канальная матрица выглядит следующим образом:

|

S1* |

S2* |

Sj* |

Sm* |

|

|

S1 |

1-P |

Po |

Po |

Po |

|

S2 |

Po |

1-P |

Po |

Po |

|

Si |

Po |

Po |

1-P |

Po |

|

Sm |

Po |

Po |

Po |

1-P |

P=(m-1)Po- вероятность ложного приёма Pnp= 1-P

Сумма вероятностей в каждой строке должна быть равна 1.

Пропускная способность.

С=maxR= при Т

при Т![]() , то есть необходимо знать количество информации.

, то есть необходимо знать количество информации.

При наличии помех можно неоднозначно определить передаваемый сигнал.

I=H-H1, где Н-это энтропия до получения сообщения.

Н1- энтропия после получения сообщения.

|

|

|

![]()

![]()

![]()

![]()

![]() xi

Si Sj* xj*

xi

Si Sj* xj*

![]() n(t)

n(t)

P(x1)= P(S1)

P(x2)= P(S2)

P(xi)= P(Si) априорные вероятности (т.е. известные до передачи сообщения)

P(xm)= P(Sm)

![]() P(S1/Sj*)

P(S1/Sj*)

P(S2/Sj*) априорные вероятности

P(Sm/Sj*)

I= H(S)- H(S/S*)

H(S)- энтропия переданных сигналов

logP(Si/Sj*)

logP(Si/Sj*)

R=1/τ{H(S)-H(S/S*)}-скорость передачи информации

С=max 1/τ {H(S)-H(S/S*)}- пропускная способность

В соответствии с 4 свойством энтропии сигналы Si и Sj* будем считать, что они выдаются двумя источниками, статистически связанными, т.е. энтропия двух источников:

H(SS*)= H(S)-H(S*/S)=H(S*)+H(S/S*)

В итоге получаем:

H(S)-H(S/S*)= H(S*)-H(S*/S), т.е. для пропускной способности можно записать:

С=max 1/τ {H(S)-H(S/S*)}-максимум будет, если H(S*) стремится к максимуму.

logP(Sj*/Si)

logP(Sj*/Si)

maxH(S*)=max{- logP(Sj*)}= logm

logP(Sj*)}= logm

P(SiSj*)=P(Si)P(Sj*/Si)

H(S*/S)=- P(Sj*/Si)logP(Sj*/Si)=-

P(Sj*/Si)logP(Sj*/Si)=- {(1-P)log(1-P)+(m-1)Po logPo}=

{(1-P)log(1-P)+(m-1)Po logPo}=

=-(1-P)log(1-P)-(m-1)Po logPo

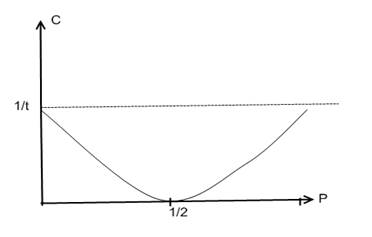

C= 1/τ {log

m+ (1-P) log (1-P) +(m-1) Po logPo}= 1/τ {log

m+ (1-P) log (1-P)+P log ![]() }

}

Т.е. пропускная способность определяет ![]()

Для Р<(m-1)/m если Po=1/m, то 1-Р= 1/m

Т.е. С=0, т.е. канал не пропускает.

Для бинарного канала m=2, тогда

С=1/τ {1+(1-P)

|

Уважаемый посетитель!

Чтобы распечатать файл, скачайте его (в формате Word).

Ссылка на скачивание - внизу страницы.