Если сигнал сообщения принимает последовательное во времени конечное число значений (при этом все они могут быть пронумерованы), сигнал называется дискретным, а сообщение, передаваемое с помощью таких сигналов — дискретным сообщением

Непрерывное сообщение может быть представлено непрерывной функцией, заданной на некотором интервале. Непрерывное сообщение можно преобразовать в дискретное. Для этого область определения функции разбивается на отрезки равной длины и на каждом из этих отрезков значение функции принимается постоянным и равным, например, среднему значению на этом отрезке. В итоге получим конечное множество чисел.

2 подхода к определению количества информации: объемный и вероятностный.

Вероятностный:

Формула Хартли: ![]() , где H – энтропия (мера неопределенности); N – число переменных. Важным при введении какой-либо величины

является вопрос о том, что принимать за единицу ее измерения. Очевидно, H будет

равно единице при N = 2. Иначе говоря, в качестве единицы принимается

количество информации, связанное с проведением опыта, состоящего в получении

одного из двух равновероятных исходов (примером такого опыта может служить

бросание монеты при котором возможны два исхода: «орел», «решка»). Такая

единица количества информации называется «бит». случае, когда вероятности Pi

результатов опыта (в примере, приведенном выше — бросания игральной кости)

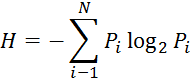

неодинаковы, имеет место формула Шеннона

, где H – энтропия (мера неопределенности); N – число переменных. Важным при введении какой-либо величины

является вопрос о том, что принимать за единицу ее измерения. Очевидно, H будет

равно единице при N = 2. Иначе говоря, в качестве единицы принимается

количество информации, связанное с проведением опыта, состоящего в получении

одного из двух равновероятных исходов (примером такого опыта может служить

бросание монеты при котором возможны два исхода: «орел», «решка»). Такая

единица количества информации называется «бит». случае, когда вероятности Pi

результатов опыта (в примере, приведенном выше — бросания игральной кости)

неодинаковы, имеет место формула Шеннона

В случае равновероятности событий ![]() , и формула Шеннона переходит в формулу

Хартли.

, и формула Шеннона переходит в формулу

Хартли.

В качестве примера определим количество информации, связанное с появлением каждого символа в сообщениях, записанных на русском языке. Будем считать, что русский алфавит состоит из 33 букв и знака «пробел» для разделения слов. По формуле Хартли H = log2 34 ~ 5.09 бит

Объемный:

В двоичной системе счисления знаки 0 и 1 называют битами (от английского выражения Binary digiTs — двоичные цифры). В компьютере бит является наименьшей возможной единицей информации. Объем информации, записанной двоичными знаками в памяти компьютера или на внешнем носителе информации, подсчитывается просто по количеству требуемых для такой записи двоичных символов.

Информатизация общества — организованный социально - экономический и научно-технический процесс создания оптимальных условий для удовлетворения информационных потребностей и реализации прав граждан, органов государственной власти, органов местного самоуправления, организаций, общественных объединений на основе формирования и использования информационных ресурсов

Информационное общество – общество, в котором большинство работающих занято производством, хранением, переработкой и реализацией информации, особенно высшей ее формы – знаний.

Цель информатизации - улучшение качества жизни людей за счет повышения производительности и облегчения условий их труда.

Основными критериями развитости информационного общества являются следующие:

Наличие компьютеров;

Уровень развития компьютерных сетей

Владение информационной культурой, т.е. знаниями и умениями в области информационных технологий

Информационные технологии — это совокупность методов, устройств и производственных процессов, используемых обществом для сбора, хранения, обработки и распространения информации.

Люди начинали считать использую свои пальцы, подручные предметы. Затем стали появляться простейшие счеты. После, стали появляться автоматические счетные машины, арифмометры. Основоположником автоматического исчисления был да

1500г. Леонардо да Винчи – эскиз 13-разрядного суммирующего устройства – 1-я попытка создания ЭВМ. 1642г. Паскаль – построил 1ую действующую суммирующую 8-разрядную машину.

1822г. Чарльз Бэббидж – «аналитическая» машина. В нее были заложены фундаментальные для вычислительной техники принципы:

Уважаемый посетитель!

Чтобы распечатать файл, скачайте его (в формате Word).

Ссылка на скачивание - внизу страницы.