Очевидно, что независимо могут вычисляться параллельные блоки, а последовательные будут выполняться только после них, на основе данных, полученных от ассинхронных процессов; Здесь тот нам и понадобится библиотека MPI, чтобы установить обмен информацией между параллельными потоками.

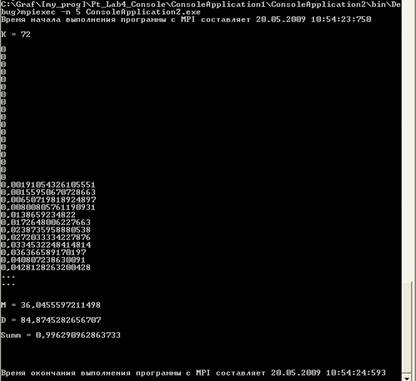

Результаты работы программы ,исспользующей MPI, представлены на рис.3:

Рис.3 Результаты работы программы, использующей MPI

Как мы видим, при исспользовании MPI программы выполнялась 843 милисекунды, т.е. почти в два раза меньше, чем программа без MPI.

Сложно не увидеть бесспорные преимущества исспользования MPI.

Время выполнения программ с MPI и без него отличается почти в два раза.

Результаты, полученные от обоих программ, абсолютно идентичны, а значит мы получаем чистый выйгрыш по скорости.

Можно со свей увереностью заявить, что MPI – это мощный инструмент, для создания расспределенных приложений, в то же время, в отличие от других инструментов – интуитивно понятный в исспользовании, хотя и не лишенный некоторой специфики, проявляющейся в необходимости внимательно составлять запрос на запуск программы.

Дальнейшее исспользование этой библиотеки представляется очень перспективным и многообещающим.

1) Л.К.Птицина, Е.В.Дорофуува «Программное обеспечение компьютерных сетей, учебное пособие»

2) Л.К.Птицина, В.Н.Цыган «Программное обеспечение ЭВМ, учебное пособие»

Уважаемый посетитель!

Чтобы распечатать файл, скачайте его (в формате Word).

Ссылка на скачивание - внизу страницы.