Лекция 2

Энтропия и информация

План:

1. Энтропия – мера неупорядоченности

2. Информация как мера знаний, необходимых для управления

3. Роль информационных машин в автоматическом управлении и их структура

У. Эшби сказал, что кибернетика – наука о том, как надо управлять очень сложной системой, чтобы она вела себя желательным для нас образом.

Конкретное выражение желательного поведения различно для различных объектов. Однако общим для них является то, что всякий процесс управления вносит в объект управления порядок или организованность, придает смысл его действиям. В связи с этим возникает задача количественного выражения упорядоченности или неупорядоченности объекта.

Предположим, что выбран признак, определяющий состояние объекта. Пусть n – число равновероятных состояний, в которых по этому признаку может находиться объект. (n=1..b).

Мера неупорядоченности F должна удовлетворять следующим признакам

1) F(1) =0

2) 2) F(n2)>F(n1) при n2>n1

3) F(n1n2)=F(n1)+ F(n2)

Таким свойствам удовлетворяет функция логарифма. Меру неупорядоченности можно записать как

S=k ln n

Величину S, выражающую неупорядоченность объекта по некоторому признаку, будем называть энтропией. Она характеризует общее состояние объекта с которым может совпадать n его возможных состояний. Энтропия также является мерой нашего незнания об объекте.

Упорядоченность объекта будет возрастать обратно пропорционально n:

-S=k ln (1/n)

Если вероятность каждого состояния р=1/n, то S=-k ln р,

и можно ввести понятие негэнтропии N=k ln p (N<0).

В

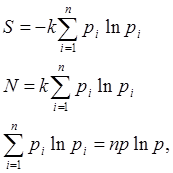

более общем случае вероятности отдельных состояний различны и

В большом количестве реализаций m этих состояний получаем

если np=1.

Наибольшая энтропия получается , если все состояния равновероятны.

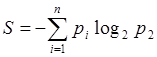

Пусть

k=log2e=1,44. Тогда S=log2n:

Эта энтропия равна единице при n=2 в том случае , если объект может равновероятно находиться в двух состояниях, то есть она выражается двоичной единицей – битом.

Задачей управления является борьба с неупорядоченностью управляемой системы посредством введения в нее негэнтропии, то есть борьба с существующей в неживой природе тенденцией к возрастанию дезорганизации. В природе происходит лишь то, что допускается прямой тенденцией, выражаемой вторым законом термодинамики (принципом Карно) , согласно которому имеет место нарастание энтропии наряду с разрушением организованных структур, стремящихся к наиболее вероятному хаотическому состоянию. Однако в открытых системах,, находящихся в состоянии энергообмена с окружающей средой, энтропия может уменьшатся .

В термодинамике рассматривается физическая энтропия

DS=DQ/T.

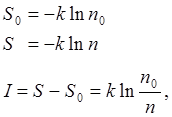

Успешное управление возможно только при наличии достаточных знаний о свойствах управляемого объекта. Ограниченность знаний заставляет допускать, что этот объект может находиться в некотором числе n0 состояний. Наблюдения позволяют увеличить это число n .

Если наблюдатель может точно охарактеризовать состояние, то n=1, но поскольку в любом опыте есть неопределенность, то n<1.

В случае, если n<n0, то знания об объекте увеличиваются . Прирост знаний можно охарактеризовать количественно: пусть

величина I – это информация.

Если

n>n0, то имеет место дезинформация:  получаемая

как результат воздействия шумов.

получаемая

как результат воздействия шумов.

Если принять I=log2(n0/n), то I=1, если n0/n=2, т.е. возможное число вероятных состояний объекта уменьшается вдвое.

Задачей оператора (регулятора) воздействующего на объект является увеличение информации об объекте. После получения информации I энтропия уменьшается

S=S0-I

как результат естественного увеличения энтропии и искусственного ее уменьшения. Этот процесс всегда требует расхода энергии, т.е. информация может быть получена только за счет негэнтропии некоторой физической системы, т.е. с общим возрастанием энтропии. Неизбежность потери информации является кибернетическим выражением второго закона термодинамики. Однако информация в отличие от энергии может быть использована многократно, благодаря чему и возможен процесс управления.

Машины, участвующие в управлении могут быть разделены на энергетические и информационные, которые характеризуются информационной мощностью.

Обработка информации по заданной программе есть детерминированный процесс, цель которого – обнаружение скрытой информации. Процесс генерации новой информации может быть реализован только в самоорганизующихся системах , которые генерируют порядок из хаоса , используя методы случайного поиска. Они не подчиняются второму закону термодинамики.

Существующие в природе управляющие системы весьма совершенны. Техническая кибернетика занимается синтезом устройств, действие которых состоит в передаче и обработке информации с целью борьбы с нарастанием физической энтропии. Они являются основой автоматизации, высвобождая от указанной задачи человека.

Автоматической системой будем называть любое устройство, действующее без участия человека.

По назначению выделяют следующие виды автоматических систем:

-системы стабилизации;

-системы программного управления;

-следящие системы;

-поисковые системы.

По принципу управления их можно разделить на

- управляемые по отклонению (с отрицательной обратной связью)

- управляемые по возмущению (разомкнутые);

- комбинированные системы.

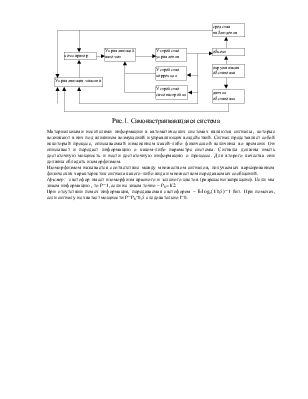

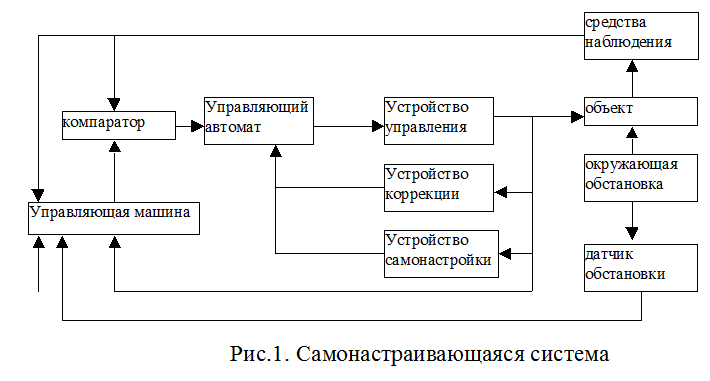

Информационные связи в автоматических системах принято показывать с помощью функциональных схем, блин, изображающих объекты и каналы связи. В качестве примера покажем структуру самонастраивающейся системы как достаточно сложной информационной машины.(рис.1)

Материальными носителями

информации в автоматических системах являются сигналы, которые возникают в них

под влиянием возмущений и управляющих воздействий. Сигнал представляет собой

некоторый процесс, описываемый изменением какой-либо физической величины во

времени. Он описывает и передает информацию о каком-либо параметре системы.

Сигналы должны иметь достаточную мощность и нести достаточную информацию о

процессе. Для второго качества они должны обладать изоморфизмом.

Материальными носителями

информации в автоматических системах являются сигналы, которые возникают в них

под влиянием возмущений и управляющих воздействий. Сигнал представляет собой

некоторый процесс, описываемый изменением какой-либо физической величины во

времени. Он описывает и передает информацию о каком-либо параметре системы.

Сигналы должны иметь достаточную мощность и нести достаточную информацию о

процессе. Для второго качества они должны обладать изоморфизмом.

Изоморфизмом называется соответствие между множеством сигналов, получаемых варьированием физических характеристик сигнала какого-либо вида и множеством передаваемых сообщений.

Пример: светофор имеет изоморфизм красного и зеленого цветов (разрешено/запрещено). Если мы знаем информацию , то Р=1, если не знаем точно – Р0=1/2.

При отсутствии помех информация, передаваемая светофором – I=log2(1/0,5)=1 бит. При помехах, если сигналу не хватает мощности Р=Р0=0,5 следовательно I=0.

Уважаемый посетитель!

Чтобы распечатать файл, скачайте его (в формате Word).

Ссылка на скачивание - внизу страницы.