БЕЛОРУССКИЙ ГОСУДАРСТВЕННЫЙ УНИВЕРСИТЕТ ТРАНСПОРТА

Кафедра «Системы передачи информации»

Отчёты

По практическим занятиям

по дисциплине

«Теория передачи сигнала»

Выполнил: Проверил:

Студент гр.ЭТ-31 доцент

Руцкого П.П. Бурченков В.В.

Гомель 2003

3.1 Результаты расчёта

Практическое занятие №2

вариант 34

Расчёт параметров текстового источника сообщения

Цель работы: определить энтропию и количество информации источника сообщения с взаимосвязанными буквами—цепь Маркова.

1. Краткие сведения из теории:

При определен количества информации, содержащейся в сообщении, достаточно рассмотреть само сообщение, или, что то же самое, выход источника информации.

Источник сообщений является дискретным, если множество сообщений, которое может быть им создано, конечно (или счётно).

Если знак на выходе К-значного источника встречается равновероятно и взаимосвязано, то количество информации, бит/знак, переносимое одним знаком максимально, определяется из соотношения

![]()

Если знаки К-значного источника встречается на выходе неравновероятно и независимо друг от друга, то энтропия рассчитывается по формуле:

В смысловом источнике информации существует вероятность взаимосвязи между буквами сообщений. Наличие такой связи уменьшает количество содержащейся в сообщении информации.

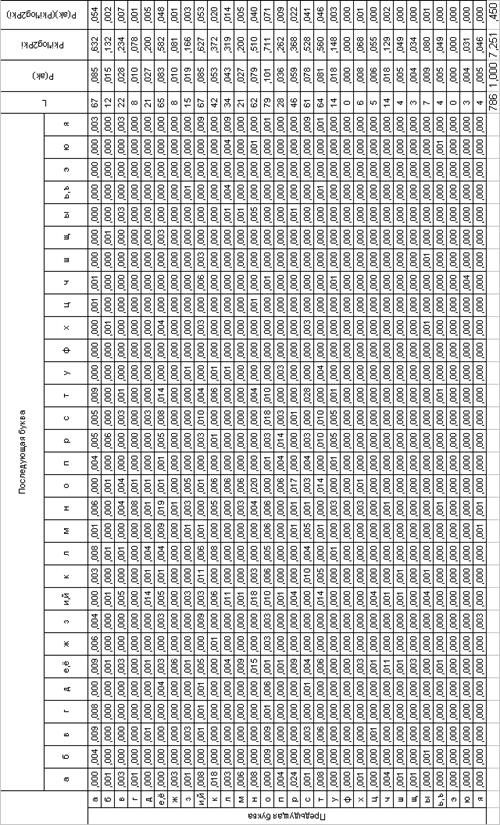

В теории информации обычно рассматривается лишь простейшая модель источника с взаимозависимыми буквами, для которого вероятностная взаимосвязь охватывает лишь каждые две смежные буквы (односвязные, простейшие цепи Маркова).

Взаимосвязь букв русского языка можно проиллюстрировать схемой (рис1.), на которой видно, что появление последующих букв в значительной степени определяется предыдущим.

рис 1

Из опыта смысловой разговорной речи известно, что появление гласной после буквы М более предсказуемо (менее определено). Поэтому количество переносимой последующей буквы информации уменьшается.

Вероятные свойства такого источника называемого Марковскими,

задаются квадратной таблицей. Эта таблица вероятностей является полной

характеристикой Марковского процесса. Вероятности появления каждой из букв

здесь определяется через ![]() (вероятность появления

буквы i после буквы к).

(вероятность появления

буквы i после буквы к).

Энтропия Марковского К- буквенного источника определяется из соотношения:

Учитывая всё вышеизложенное ![]() .

.

2. Методика выполнения работы

2.1 Максимальная энтропия.

2.2 Относительная избыточность.

2.3 Определение коэффициента сжатия.

2.4 Определение количества информации.

3. Исходные данные.

Исходный текс:

диагностика устроиств общее положение диагностика устроиств производится в окне диагностика сети и необходимо для просмотра состояния технических средств аск пс и каналов связи а также для тестирования устроиств с целью локализации отказов окно диагностика сети выбирается через меню или клавишеи в окне отображается мнемосхема всех технических средств аск пс и каналов связи если вся мнемосхема не помещается в окно то ее можно просматривать по частям сдвигая изображение клавишами управления курсором или отметкои мыши шкалы перемещения диагностика пунктов контроля условно изображенных в виде стоек диска понаба или ктсм производится автоматически методом циклического опроса результат диагностики отображается изменением цвета изображения пунктов контроля черныи нормальная работа красныи отказ бледно зеленыи отключен или не исправен возникает при выключении питания станционнои стоики диск или при неподключенном разьеме кабеля к аппаратуре контроля в случае аппаратуры ктсм означает наличие неисправностеи а аппаратуре для уточнения характера неисправности

3.1.1 Максимальная энтропия источника:

![]()

3.1.2 Относительная избыточность:

3.1.3 Определяем коэффициент сжатия:

3.1.4 Определяем количество информации:

![]() бит

бит

4. Вывод: в данной работе определены параметры источника сообщения. Из расчёта следует, что избыточность нашего источника информации составляет 95.4% т.е. этот источник информации работает нерационально, а коэффициент сжатия показывает, что сообщение сжато на 4.5%.Количество информации равно 5699 бит.

16.09.2003 ____________

Уважаемый посетитель!

Чтобы распечатать файл, скачайте его (в формате Word).

Ссылка на скачивание - внизу страницы.